Web Scraping là gì? tìm hiểu web scraping – w3seo tại sao sử dụng

Chào mừng bạn đến với pgdgiolinhqt.edu.vn trong bài viết về Web scraping va data mining khac gi nhau chúng tôi sẽ chia sẻ kinh nghiệm chuyên sâu của mình cung cấp kiến thức chuyên sâu dành cho bạn.

Lướt web là một công cụ cực kỳ hữu ích để thực hiện nghiên cứu trực tuyến. Nó được sử dụng bởi các tập đoàn lớn và cá nhân như nhau để nghiên cứu tất cả các dữ liệu khác nhau mà internet cung cấp. Nó có thể giúp các doanh nghiệp và mọi người dễ dàng thu thập thông tin để họ có thể đưa ra các quyết định dựa trên dữ liệu tốt hơn.

Các bài viết liên quan:

- Các công thức Google Sheets dành tặng cho SEO

- Các câu hỏi cần thiết khi phỏng vấn SEO

- Cách tạo và sử dụng nội dung theo hướng dữ liệu để xây dựng liên kết

- Schema là gì?

- Từ khóa là gì?

Dưới đây là những điều bạn cần biết về tính năng quét web, cách thức hoạt động và lý do bạn cần sử dụng proxy để tận dụng tối đa công cụ hữu ích này.

Web Scraping là gì?

Việc tìm kiếm trên web đơn giản hơn bạn nghĩ. Hãy nghĩ về Internet giống như một thanh sô cô la lớn tuyệt vời được làm bằng thông tin. Nếu bạn muốn sử dụng một ít sô cô la đó cho công thức làm bánh, bạn không cần phải cắt một phần lớn thanh. Bạn chỉ cần scrapnó và thu thập các mảnh vụn.

Bạn có thể làm điều đó với các trang web. Nếu bạn muốn sử dụng một số thông tin từ một trang web để nghiên cứu, bạn có thể sử dụng một công cụ để “quét” trang web đó. Trong trường hợp này, scraplà quá trình truy cập trang web và tự động sao chép dữ liệu bạn cần. Trang web vẫn ở đó, nhưng bạn đã thu thập được những gì bạn muốn và tiếp tục hành trình của mình.

Thông thường, việc quét web được thực hiện bằng một phần mềm được gọi là trình duyệt web. Đây là một bot – một chương trình tự động – truy cập các trang web để thu thập thông tin bạn muốn. Bot có thể truy cập các trang web hàng chục lần – nhanh hơn nhiều lần so với con người – và thu thập dữ liệu mà không mắc lỗi. Điều đó cho phép bạn tìm kiếm hàng chục, hàng trăm hoặc thậm chí hàng nghìn trang web để tìm dữ liệu bạn cần. Sau khi kết thúc tìm kiếm, bot sẽ tạo ra một bảng tính đầy đủ thông tin mà bạn có thể nghiên cứu và sử dụng thông tin theo cách bạn muốn.

Các bài viết liên quan:

- Kiểm tra lỗ hổng bảo mật HTTP Incoming Requests

- Responsive Web là gì?

- Web Cache là gì?

- Hướng dẫn python

- Proxy server là gì?

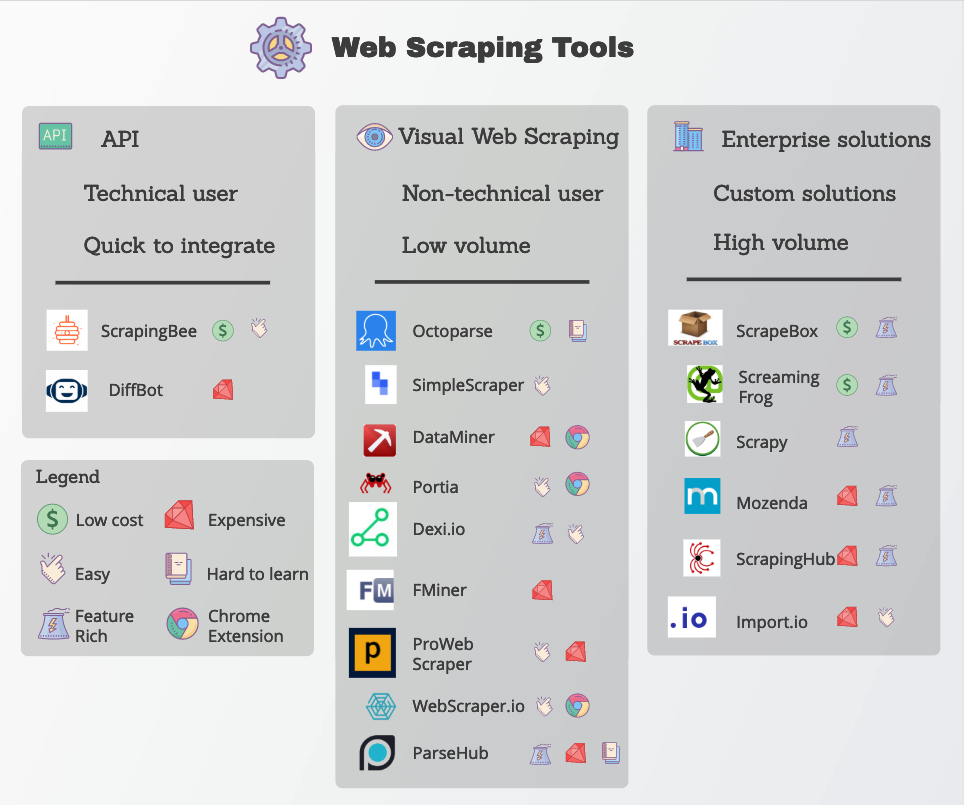

API Web Scraping là gì?

API (Giao diện lập trình ứng dụng) là một chương trình giúp tự động hóa các chương trình và liên kết chúng với nhau. Bạn có thể sử dụng API trong nhiều trường hợp khác nhau, nhưng chúng đặc biệt hữu ích trong việc tìm kiếm trên web.

Trình tìm kiếm trang web tiêu chuẩn yêu cầu bạn chạy toàn bộ quy trình sàng lọc theo cách thủ công, từ việc nhập địa chỉ web đến thu thập dữ liệu. API có thể giúp bạn tránh điều đó. Bạn có thể sử dụng API để thu thập dữ liệu trang web trong thời gian thực, bất cứ khi scrap bạn muốn.

API có thể hữu ích nếu bạn muốn thu thập thông tin về một chủ đề nhất định. Bạn có thể sử dụng API để tự động quét các trang web ưa thích của mình mỗi phút một lần, hai lần một giờ hoặc bất kỳ khoảng thời gian scrap bạn muốn.

Mục đích của Web Scraping là gì?

Bạn biết việc scrap web – nhưng mục đích của việc scrap web là gì? Tại sao nó quan trọng?

Lướt web là cách hiệu quả nhất để thu thập một lượng lớn dữ liệu từ các trang web. Toàn bộ mục đích của nó là thu thập thông tin cụ thể một cách nhanh chóng. So với nghiên cứu thủ công, nó tiết kiệm thời gian ấn tượng và cũng chính xác hơn. Không có rủi ro do lỗi do con người hoặc lỗi chính tả vì người quét dữ liệu trang web thu thập nguyên văn dữ liệu trang web thông qua việc sao chép và dán dữ liệu đó.

Làm thế scrap bạn có thể sử dụng Web Scraping

Bạn có thể sử dụng tính năng tìm kiếm trên web theo nhiều cách – đó là một công cụ hữu ích rộng rãi như công cụ tìm kiếm nếu bạn biết cách sử dụng nó.

Các doanh nghiệp sử dụng web scrapmọi lúc. Thật dễ dàng để triển khai tìm kiếm web trong nghiên cứu của công ty về bất cứ điều gì mà một công ty có thể muốn tìm hiểu.

Thiết lập giá: Rất nhiều doanh nghiệp đặt giá của họ dựa trên giá của các đối thủ cạnh tranh. Bạn có thể đi và thu thập giá sản phẩm theo cách thủ công, truy cập trang web của đối thủ cạnh tranh hàng giờ và viết ra những gì bạn tìm thấy. Hoặc bạn có thể sử dụng một chương trình duyệt web và thu thập tất cả thông tin giá cả bạn muốn trong một khoảng thời gian ngắn – mà không cần phải tự mình làm bất cứ điều gì.

Nghiên cứu đánh giá: Nếu một công ty muốn cải thiện sản phẩm của mình, công ty có thể sử dụng công cụ tìm kiếm trên web để tìm hiểu cách thực hiện. Doanh nghiệp của bạn có thể thu thập các bài đánh giá của chính mình và của đối thủ cạnh tranh để tìm hiểu những gì mọi người thích và những gì không hiệu quả. Bằng cách đó, bạn có thể cải thiện những phàn nàn lớn nhất của khách hàng mà không mắc phải những sai lầm tương tự như các doanh nghiệp khác.

Giám sát phương tiện truyền thông xã hội: Danh tiếng của thương hiệu là tài sản quan trọng nhất của thương hiệu. Các công ty muốn đảm bảo rằng thương hiệu của họ đang được nhắc đến một cách tích cực trên mạng. Lướt web có thể giúp một công ty theo dõi các lượt đề cập đến thương hiệu của mình để xem mọi người nói gì.

Không chỉ các doanh nghiệp mới có thể tận dụng tính năng tìm kiếm trên web. Bạn có thể sử dụng web scrapở nhà cho các dự án cá nhân của tất cả các loại.

Tìm kiếm giao dịch: Một API duyệt web đơn giản có thể giúp bạn theo dõi mọi thứ, từ giá quà tặng bạn muốn mua đến giá vé máy bay. Bạn thậm chí có thể thiết lập tìm kiếm của mình để cho bạn biết khi scrap có chương trình giảm giá quá tốt để bỏ lỡ.

Kiểm tra chất lượng: Nếu bạn sắp thực hiện một giao dịch mua lớn, bạn có thể rà soát các bài đánh giá để tìm ra lựa chọn tốt nhất.

Sự tò mò của cá nhân: Bạn có thể sử dụng tính năng tìm kiếm trên web để trả lời những câu hỏi kỳ lạ mà bạn có hoặc lấy thêm thông tin về bất kỳ dự án nghiên cứu internet cá nhân scrap khác sẽ rất tẻ nhạt nếu không có sự trợ giúp.

Những thách thức của Web Scraping

Việc tìm kiếm trên web không hoàn toàn phức tạp như sử dụng công cụ tìm kiếm. Nhiều chủ sở hữu trang web không thích “lãng phí” tài nguyên cho khách truy cập bot. Quan trọng hơn, một số trang web đang lo lắng về các nỗ lực tấn công như tấn công DDoS. Trong các cuộc tấn công này, tin tặc sử dụng bot để truy cập một trang web nhiều lần, sử dụng hết tài nguyên của nó và làm sập nó. Vì cả hai lý do này, các trang web thường có các biện pháp bảo mật được cho là phát hiện và chặn bất kỳ bot scrap truy cập.

Điều đó dẫn đến một thách thức lớn đối với những người tìm kiếm web hợp pháp. Khi một chương trình bảo mật trang web quyết định rằng khách truy cập là bot, nó sẽ xác định khách truy cập thông qua địa chỉ IP của họ. Điều này giống như sự giao nhau giữa địa chỉ nhà riêng của máy tính và thẻ ID. Để ngăn bot truy cập hoặc tấn công, chương trình bảo mật sẽ chặn IP của bot. Không ai từ địa chỉ IP đó có thể truy cập lại trang web. Đây rõ ràng là một vấn đề nếu bạn đang cố gắng nghiên cứu trang web. May mắn thay, có một giải pháp.

Proxy phải làm gì với Web Scraping?

Khi bạn đang tìm kiếm một trang web, bạn cần phải cẩn thận để tránh bị chặn địa chỉ IP của mình. Nếu IP thực của bạn bị chặn, bạn có thể không bao giờ truy cập được vào trang web đó nữa. Nếu bạn (thực sự) lo lắng về việc bị chặn và đưa vào danh sách đen, có một giải pháp dễ dàng: proxy.

Proxy là gì?

Proxy là địa chỉ IP mà bạn có thể sử dụng để che địa chỉ cá nhân của mình. Nó giống như một địa chỉ chuyển tiếp. Khi bạn sử dụng proxy, tất cả các tương tác internet của bạn trước tiên được định tuyến từ IP của bạn thông qua proxy, sau đó đến trang web bạn đang truy cập. Bằng cách này, trang web không bao giờ nhìn thấy địa chỉ thực của bạn. Nếu proxy bị chặn, bạn vẫn an toàn.

Có hai loại proxy chính mà bạn có thể sử dụng: proxy trung tâm dữ liệu và proxy dân cư. Sự khác biệt giữa hai là vị trí nơi proxy được lưu trữ.

Trung tâm dữ liệu Proxy

Như tên gọi, proxy trung tâm dữ liệu được lưu trữ trong một trung tâm dữ liệu. Những proxy này rẻ vì trung tâm có nhiều tài nguyên để lưu trữ và tạo ra các IP mới. Tuy nhiên, chúng cũng dễ xác định vì chúng không đi kèm với số hệ thống tự quản của khu dân cư (ASN). Về cơ bản, rõ ràng đối với các chương trình bảo mật trang web rằng proxy đang được sử dụng, vì vậy, các trang web có nhiều khả năng chặn IP trung tâm dữ liệu hơn.

Proxy của khu dân cư

Trong khi đó, proxy khu dân cư thường được lưu trữ tại nơi ở của ai đó. Các IP proxy này có ASN khu dân cư mà chúng được nhà cung cấp dịch vụ internet (ISP) chỉ định. Do đó, họ trông giống như một người dùng Internet thực sự của con người. Tuy nhiên, vì chúng được tổ chức thông qua nhà của ai đó nên chúng cũng có giá scraphơn.

Cách tốt nhất để sử dụng bất kỳ dịch vụ proxy scrap để quét web là sử dụng proxy xoay vòng. Proxy luân phiên thực sự là một tập hợp các proxy. Nhà cung cấp tự động thay đổi proxy mà bạn đang định tuyến lưu lượng truy cập của mình thường xuyên. Điều này giúp proxy của bạn tránh bị chặn. Không có proxy đơn lẻ scrap được sử dụng trên cùng một trang web đủ lâu để kích hoạt các biện pháp bảo mật. Nếu bạn muốn có hệ thống proxy đáng tin cậy nhất có thể, dịch vụ proxy dân dụng luân phiên của W3 SEO là hoàn hảo cho bạn.

Các công cụ khác cho Web Scraping

Bạn cũng có thể sử dụng proxy kết hợp với các công cụ khác. Ví dụ: W3 SEO’s Proxy Pilot là một công cụ tuyệt vời để xử lý các vấn đề quản lý proxy trước khi chúng bắt đầu. Với Proxy Pilot, bạn có thể lập trình xoay vòng proxy theo bất kỳ cách scrap bạn muốn. Bạn thậm chí có thể sử dụng Proxy Pilot để phát hiện các lệnh cấm và thay thế các lệnh cấm khác một cách tự động. Đó là cách tốt nhất để làm cho việc tìm kiếm web bằng proxy trở nên hoàn toàn hữu ích.

Tương tự như vậy, một API như Scraping Robot có thể giúp bạn lập lịch quét web phối hợp với proxy của bạn. Giải pháp scrap tùy chỉnh này hoàn hảo để xử lý tất cả các nhu cầu scraptrên web của bạn, hoàn chỉnh với việc tích hợp với các proxy W3 SEO.

Lời kết

Nếu bạn đã sẵn sàng bắt đầu thực hiện nghiên cứu chuyên sâu, trực tuyến, thì đã đến lúc cân nhắc việc tìm kiếm trên web.

Lướt web là cách dễ nhất để thu thập tất cả dữ liệu bạn cần khi bạn cần. Với những proxy phù hợp, bạn có thể thực hiện mọi việc mà không gặp rủi ro.

Cho dù bạn cần một bộ sưu tập lớn các proxy trung tâm dữ liệu hay lựa chọn các proxy dân cư luân phiên cho nghiên cứu của mình, W3 SEO đều có thể trợ giúp. Kết hợp với Proxy Pilot, bạn có thể tự động nghiên cứu tất cả các trang web bạn muốn từ mọi nơi trên thế giới. Hãy liên hệ ngay hôm nay để tìm hiểu cách bạn có thể sử dụng W3 SEO để làm cho việc tìm kiếm web nhanh chóng, an toàn và dễ dàng.